Was ist ein Crawler? Crawler-Tool "Yandex" und Google

Jeder Tag im Internet gibt es eine riesige Menge an neuen Materialien eine Website aktualisiert, um die alten Web-Seiten zu erstellen, Fotos und Videos hochladen. Ohne von Suchmaschinen versteckt konnte nicht im World Wide Web, keines dieser Dokumente gefunden werden. Alternativen wie Roboterprogramme zu einem bestimmten Zeitpunkt nicht existieren. Was ist ein Suchroboter, warum Sie es brauchen und wie zu bedienen?

Was ist ein Roboter suchen

Crawler-Website (Suchmaschine) – es ist ein automatisches Programm, das fähig ist, die Millionen von Web-Seiten zu besuchen, schnell der Navigation durch das Internet ohne Eingreifen des Bedieners. Bots sind ständig Scan Raum des World Wide Web, neue Web – Seiten zu finden und regelmäßig bereits indiziert besuchen. Andere Namen für Web-Crawler Spider, Crawler, Bots.

Warum sind Spinnen Suchmaschine

Die wichtigsten Funktionen, die Suchmaschinen durchführen – Webseite indiziert, sowie Texte, Bilder, Audio- und Videodateien, die auf sie sind. Bots überprüfen Referenzen, Mirror-Sites (Kopien) und Updates. Die Roboter auch die HTML-Code-Steuerung für Konformitätsstandards der Weltorganisation, die entwickelt führen und setzt technologische Standards für das World Wide Web.

Was ist die Indizierung, und warum es nötig ist

Indizierung – ist in der Tat ist der Prozess der eine bestimmte Web-Seite von Suchmaschinen zu besuchen. Das Programm durchsucht den Text auf dieser Seite, Bilder, Videos, ausgehende Links, dann wird die Seite in den Suchergebnissen. In einigen Fällen kann die Seite nicht automatisch gescannt wird, dann kann es an die Suchmaschine Webmaster manuell hinzugefügt werden. Normalerweise geschieht dies in Abwesenheit von externen Links auf eine bestimmte (oft erst vor kurzem erstellt) Seite.

Wie Suchmaschinen-Spider

Jede Suchmaschine hat einen eigenen Bot mit dem Roboter Google-Suche kann variiert deutlich nach dem Mechanismus arbeitet an einem ähnlichen Programm, „Yandex“ oder anderen Systemen.

Im Allgemeinen ist ein Roboter Arbeitsprinzip ist wie folgt: Das Programm „kommt“ auf der Website und externe Links auf der Hauptseite „lesen“ Web-Ressource (einschließlich diejenigen, die Overhead, der den Benutzer nicht sehen). Boot ist, wie zwischen den Seiten einer Website zu navigieren und zu anderen bewegen.

Das Programm wird entscheiden, welche Website zu indizieren? Mehr als oft nicht mit Nachrichten-Websites oder großen Ressourcen-Verzeichnissen und Aggregatoren mit großen Referenzgewicht „TRIP“ die Spinne beginnt. Crawler durchsucht kontinuierlich die Seiten nacheinander, auf die Geschwindigkeit und Konsistenz folgende Faktoren von der Indizierung:

- Intern: perelinovka (interne Verbindungen zwischen den Seiten der gleichen Ressource), Platzgröße, der richtigen Code, benutzerfreundlich und so weiter;

- Extern: das Gesamtreferenzgewicht, das auf die Website führt.

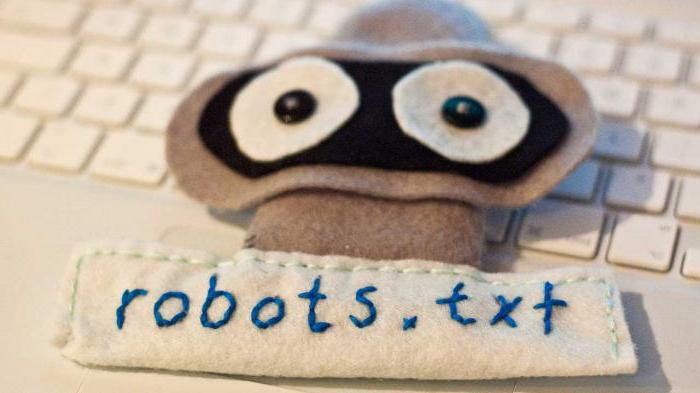

Das erste, was die Suchroboter Suche auf einer Website von robots.txt. Weitere Ressourcenindexierungs erfolgt auf der Grundlage der erhaltenen Informationen aus diesem Dokument. Diese Datei enthält spezielle Anweisungen für die „Spinnen“, die die Chancen der Seite Besuche von Suchmaschinen erhöhen, und damit eine frühe Hit-Stelle in der „Yandex“ oder Google zu erreichen.

Programm-Analoga Crawlern

Oft wird der Begriff „Suchroboter“ mit intelligenten, Benutzern oder autonomen Agenten verwechselt, „Ameisen“ oder „Würmer“. Eingebettet signifikante Unterschiede nur im Vergleich mit Agenten verweisen andere Definitionen auf ähnliche Arten von Robotern.

Zum Beispiel können Mittel sein:

- intellektuell: das Programm, das von Ort zu Ort bewegt werden, unabhängig zu entscheiden , wie zu verfahren; sie sind nicht sehr häufig im Internet;

- Autonome: Diese Mittel helfen dem Anwender in einem Produkt, Suche auswählen, oder das Ausfüllen von Formularen, die so genannten Filter, die auf Netzwerkprogramme wenig verwandt sind;.

- Benutzer: das Programm einen Beitrag zur Interaktion des Benutzers mit dem World Wide Web, einen Browser (zB Opera, IE, Google Chrome, Firefox), Boten (Viber, Telegramm) oder E-Mail – Programmen (MS Outlook und Qualcomm).

„Ameisen“ und „Würmer“ sind ähnlich wie die Suchmaschine „Spinnen“. Die erste Form zwischen einem Netzwerk und konsequent wie diese Ameisenart interagieren, „Würmer“ in der Lage, in anderer Hinsicht die gleiche wie die Standard-Crawler zu replizieren.

Vielzahl von Suchmaschinen-Robots

Unterscheiden Sie zwischen vielen Arten von Raupen. Je nach Zweck des Programms, sind sie:

- "Mirror" – Dubletten-Websites durchsuchen.

- Mobile – Fokus auf mobile Versionen von Web-Seiten.

- Schnell – fix neue Informationen schnell durch das neueste Updates sehen.

- Referenz – Referenzindex, zählen ihre Zahlen.

- Indexer verschiedene Arten von Inhalten – spezifische Programme für Text, Audio, Video, Bilder.

- „Spyware“ – Suche nach Seiten, die in der Suchmaschine noch nicht angezeigt werden.

- „Woodpecker“ – regelmäßig Websites besuchen, um ihre Relevanz und Effizienz zu überprüfen.

- National – Surfen im Internet auf einem der Länder-Domains liegt Ressourcen (zB .mobi oder .kz .ua).

- Global – Index alle nationalen Websites.

Robots große Suchmaschinen

Es gibt auch einige Suchmaschinen. In der Theorie kann ihre Funktionalität ist sehr unterschiedlich, aber in der Praxis sind die Programme fast identisch. Die wichtigsten Unterschiede Web-Seiten indexiert Roboter zwei großen Suchmaschinen sind wie folgt:

- Die Stringenz der Prüfung. Es wird angenommen, dass der Mechanismus des Crawler „Yandex“ etwas strengere Schätzungen der Standort für die Einhaltung der Standards des World Wide Web.

- Die Erhaltung der Integrität der Website. Die Google-Crawler indexiert die gesamte Website (einschließlich Medieninhalte), „Yandex“ kann auch sehen Inhalt selektiv.

- Speed – Test neue Seiten. Google fügt neue Ressource in den Suchergebnissen innerhalb von wenigen Tagen, im Fall von „Yandex“ Prozess 2 Wochen oder länger dauern kann.

- Die Häufigkeit der Neuindexierung. Crawler „Yandex“ nach Updates zweimal pro Woche, und Google – ein alle 14 Tage.

Internet, natürlich nicht auf die beiden Suchmaschinen beschränkt. Andere Suchmaschinen haben ihre Roboter, die ihre eigenen Indexierungsparameter folgen. Darüber hinaus gibt es mehr „Spinnen“, die keine größere Such Ressourcen ausgelegt sind, und einzelne Teams oder Webmaster.

häufige Missverständnisse

Entgegen der landläufigen Meinung, „Spinnen“ verarbeiten die Informationen nicht. Das Programm nur scannt und speichert Webseiten und Weiterverarbeitung nimmt einen ganz anderen Roboter.

viele Anwender glauben auch, dass die Suchmaschinen haben einen negativen Einfluss und „schädlich“ Internet. In der Tat können einige Versionen von „Spinnen“ Überlastung deutlich den Server. Es gibt auch ein Faktor Mensch – der Webmaster, der das Programm erstellt haben, können Fehler in der Roboter-Konfiguration vornehmen. Doch die meisten der bestehenden Programme sind gut gestaltet und professionell verwaltet und alle neu auftretende Probleme umgehend entfernt.

Wie die Indizierung verwalten

Suchmaschinen-Roboter sind die automatisierten Programme, aber der Indexierungsprozess kann teilweise durch den Webmaster gesteuert werden. Das hilft sehr externe und interne Optimierung der Ressource. Darüber hinaus können Sie manuell einen neuen Standort zu einer Suchmaschine hinzufügen: große Ressourcen, um eine besondere Form von Web-Seiten Registrierung haben.