Wenn eine Person in der Studie der Computertechnik tätig ist , ist nicht oberflächlich, aber ernst, muss es sicherlich bewusst sein , was die verschiedenen sind Formen von Informationen in dem Computer ein . Diese Frage ist ein grundlegende, weil nicht nur die Verwendung von Software und Betriebssystemen, sondern auch die Programmierung im Prinzip auf der Grundlage dieses Ahas ist.

Lesson „Präsentation der Informationen in den Computer“: Die Grundlagen

Im Allgemeinen Computerausrüstung für die Art und Weise wahrnehmen sie die Informationen oder Befehle, wandelt sie in die Dateiformate und stellt den Anwender das fertige Ergebnis ist etwas verschieden von den herkömmlichen Konzepten.

Die Tatsache, dass alle bestehenden Systeme auf Basis von nur zwei logischen Operatoren – „wahr“ und „falsch» (wahr, falsch). In einem einfacheren Sinne ist es „ja“ oder „nein“.

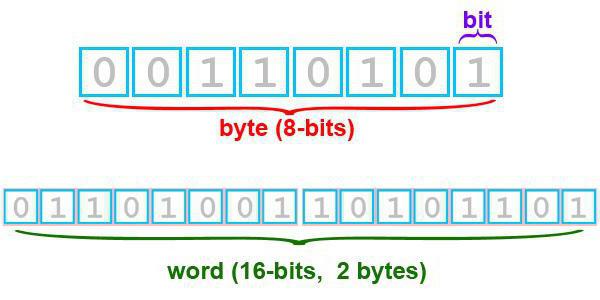

Es versteht sich, dass die Worte Informatik versteht nicht, warum ein spezielles digitales System mit bedingten Code zu Beginn der Computer-Technologie erstellt wurde, in dem die Zustimmung der betreffenden Einheit und Denial – Null. Das ist genau das, was die sogenannte binäre Darstellung von Informationen in einem Computer erschien. Je nach Kombination von Einsen und Nullen wird bestimmt , und die Größe des Datenobjekts.

Die kleinste Einheit dieser Art ist die Größe ein Bit – Bit, das entweder den Wert 0 oder 1 jedoch moderne Systeme mit so geringen Mengen nicht funktionieren, und fast alle Möglichkeiten der Darstellung der Informationen im Computer werden reduziert mit nur acht Bits haben können, die zusammen bilden Bytes (2 auf die achte Leistung). Somit kann in einem einzigen Byte eines Zeichencodierung von 256 möglich gemacht werden. Und es ist ein Binärcode das Fundament für jede der Informationsobjekt ist. Es versteht sich, wie es in der Praxis aussieht.

Informatik: die Bereitstellung von Informationen in den Computer ein. Festkommazahl

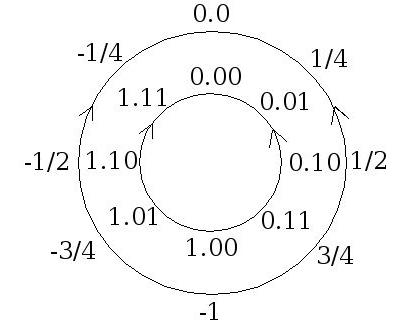

Da es sich ursprünglich über Zahlen zu sprechen war, sehen wir, wie das System sie behandelt. Darstellung numerischer Information in den Computer heute lassen sich in Verarbeitung Nummern mit festen und Gleitkomma unterteilt werden. Der erste Typ kann auch gewöhnliche ganze Zahlen zurückgeführt werden, die nach dem Komma ist wert Null.

Es wird angenommen, dass die Anzahl von diesem Typ 1 erfolgen kann, 2 oder 4 Bytes. Das so genannte Kopf-Byte ist für das Vorzeichen der Zahl verantwortlich, während ein positives Vorzeichen auf Null entspricht, und negativ – Einheit. So kann zum Beispiel eine 2-Byte – Darstellung des Bereichs von Werten für positive Zahlen im Bereich von 0 bis 16 1. Februar , die 65535 ist, und für negative Zahlen – -2 15 bis 2 15 -1, was einem Zahlenbereich gleich ist aus -32768 bis 32767.

Gleitkommadarstellung

Betrachten wir nun die zweite Art von Zahlen. Die Tatsache , dass der Schule Lehrplan Unterricht auf „Berichterstattung auf einem Computer“ (Klasse 9) Gleitkommazahlen werden nicht berücksichtigt. Operationen mit ihnen sind sehr komplex und werden beispielsweise in Computerspielen. By the way, ein wenig vom Thema abgelenkt, sollte man sagen, dass für moderne Grafikkarten eine der wichtigsten Indikatoren für die Leistung die Geschwindigkeit der Transaktionen ist mit solchen Zahlen.

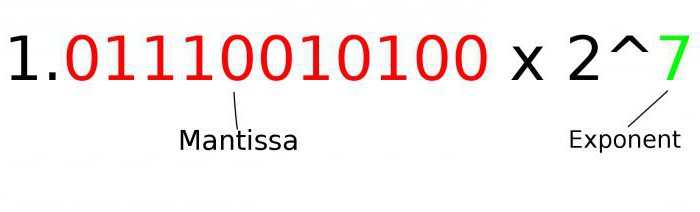

Hier verwenden wir die exponentielle Form, in der die Position des Dezimalpunktes geändert werden kann. Da die Grundformel, um eine Darstellung einer beliebigen Anzahl von akzeptierten ein folgendes zeigt: A = m A * q P , wobei A m – ist die Mantisse, q P – a radix ist und P – Bestell – Nr.

Die Mantisse muss die Anforderung von q erfüllen -1 ≤ | m A | <1, dann muss es richtig sein Binärbruch die Ziffer hinter dem Komma enthält, die von Null, und die Reihenfolge der anders ist – eine ganze Zahl. Und jede normalisiert Dezimalzahl kann sehr einfach sein, in exponentieller Form vorzustellen. Und die Zahl dieser Art hat eine Größe von 4 oder 8 Bytes.

Zum Beispiel sieht die Dezimalzahl 999.999 gemäß der Formel mit einer normalisierten Mantisse wird wie 0,999999 ~ 10 3.

Anzeigen der Textdaten: ein bisschen Geschichte

Die meisten von allen Benutzern von Computersystemen immer noch die Testinformationen. Und sehen die Textinformationen in dem Computer der gleichen binären Code Prinzipien entsprechen.

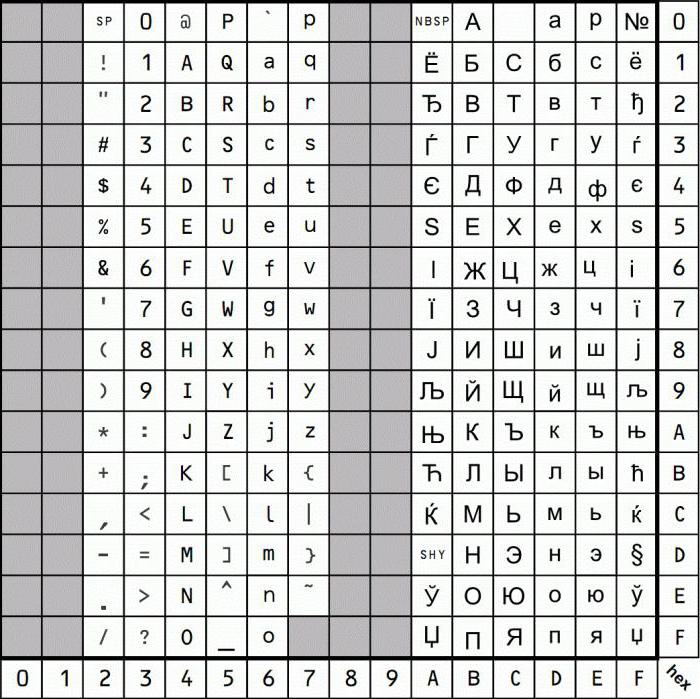

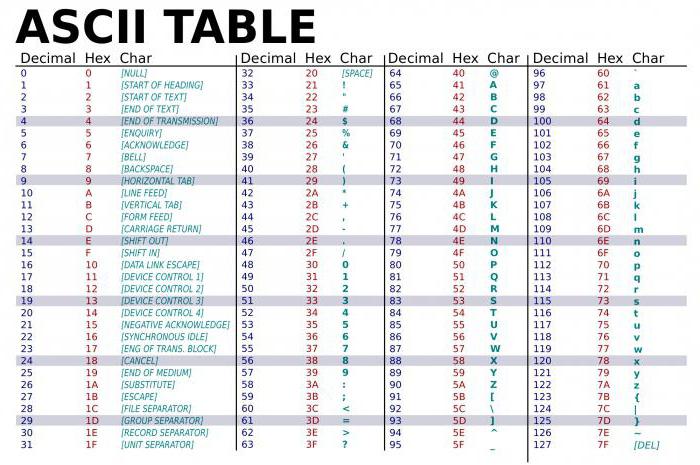

Aufgrund der Tatsache, dass wir heute viele Sprachen der Welt zählen, Textinformationen darzustellen verwendet spezielle Codierungen System oder Codetabellen. Mit dem Aufkommen von MS-DOS wurde einen grundlegenden Standard kodiert CP866 angesehen und Apple Mac-Computer wird seinen eigenen Standard verwenden. Während eine spezielle ISO 8859-5-Codierung wurde in der russischen Sprache eingeführt. Doch mit der Entwicklung der Computertechnologie notwendig, um neue Standards einzuführen.

Vielzahl von Codierungen

Zum Beispiel in den späten 90-er Jahren des letzten Jahrhunderts war es eine universelle Kodierung von Unicode, die nicht nur Textdaten verarbeiten kann, sondern auch Audio und Video. Seine Besonderheit besteht darin, dass ein einzelnes Zeichen wurde mehr als ein Bit zugeordnet, sondern zwei.

Ein wenig später, es gibt auch andere Sorten. Für Windows-basierte Systeme, die am häufigsten verwendete ist die Kodierung CP1251, aber für die russische Sprache und wird verwendet, noch von Koi-8P – Codierung, die in den späten 70er Jahren erschienen und 80er Jahren wurden auch in UNIX-basierten Systemen aktiv genutzt.

Die gleichen Informationen in Textdarstellung eines Computers auf der ASCII-Tabelle basiert, mit einer Basis und einem verlängerten Abschnitt. Die erste enthält Codes von 0 bis 127, die zweiten – von 128 bis 255. Jedoch ist der erste Bereichscodes 0-32 über die Symbole zurückgezogen, die die Tasten einer Standardtastatur und die Funktionstasten (F1-F12) zugeordnet sind.

Grafik: die wichtigsten Arten von

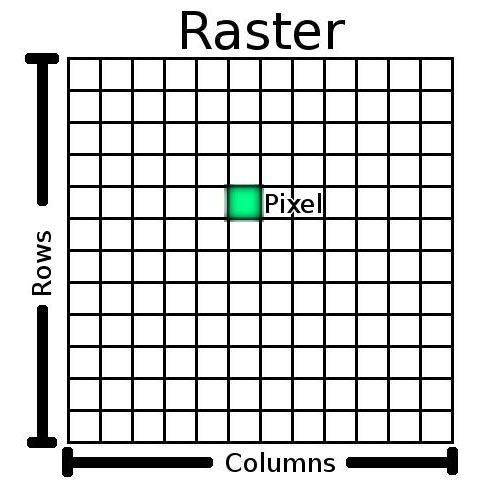

Als für die Grafiken, die weit in der heutigen digitalen Welt verwendet wird, gibt es einige Nuancen. Wenn Sie bei der grafischen Darstellung von Informationen in einem Computer suchen, müssen Sie zuerst die Aufmerksamkeit auf die wichtigsten Arten von Bildern zahlen. Unter ihnen sind zwei Haupttypen – Vektor- und Raster.

Vektor-Grafiken basierend auf der Verwendung von primitiven Formen (Linien, Kreise, Kurven, Polygone, und so weiter. D.), Textfelder und füllt eine bestimmte Farbe. Bitmaps werden auf die Verwendung einer rechteckigen Matrix basiert, von denen jedes Element ein Pixel genannt wird. Darüber hinaus ist für jedes Element können Sie die Helligkeit und Farbe einstellen.

Vektor-Bild

Heute ist die Verwendung von Vektor hat eine begrenzte Fläche. Sie sind gut, zum Beispiel bei der Erstellung von technischen Zeichnungen und Diagramme oder für zweidimensionale oder dreidimensionale Modelle von Objekten.

Beispiele stationäre Vektorformen sind Formate wie PDF, WMF, PCL. Für Formen hauptsächlich gebrauchten Macromedia Flash-Standard zu bewegen. Aber wenn wir über die Qualität oder die Durchführung komplexer Operationen als im gleichen Maßstab zu sprechen, ist es besser, Rasterformate zu verwenden.

Bitmaps

Mit Rasterobjekten ist es viel komplizierter. Die Tatsache, dass die Präsentation von Informationen, die in der computerbasierten Matrix, die die Verwendung von zusätzlichen Parametern beinhaltet – Farbtiefe (quantitative Expression von Palettenfarben) in Bits und die Matrixgröße (Anzahl der Pixel pro Zoll, bezeichneten als DPI).

Das heißt, die Palette 16 bestehen, 256, 65536 oder 16.777.216 Farben, und die Matrix kann variieren, aber die häufigste ist eine Auflösung von 800×600 Pixeln (480 000 Bildpunkte) bezeichnet. Nach diesen Indikatoren die Anzahl der Bits zu bestimmen, erforderlich, um das Objekt zu speichern. Dazu verwenden wir zunächst die Formel N = 2 I, in der N – die Anzahl der Farben, und ich – ist eine Farbtiefe.

Dann die Informationsmenge berechnet. Um beispielsweise die Größe der Datei, Bild enthält 65.536 Farben und eine Matrix von 1024×768 Bildpunkten zu berechnen. Die Lösung ist wie folgt:

- I = 2 65536 einzuloggen, dh 16 Bits;

- die Anzahl der Pixel 1024 * 768 = 786 432;

- Speicherkapazität beträgt 16 Bits * 432 = 12 786 582 912 Bytes, die auf 1,2 Mb entspricht.

Vielzahl von Audio: die Hauptrichtung der Synthese

Darstellung von Informationen in einem Computer, die so genannte Audio, unterliegen den gleichen Grundprinzipien, die oben beschrieben wurden. Aber, wie für jede andere Form von Informationsobjekten des Ton darstellen, auch verwendet, um ihre zusätzliche Funktionen.

Leider hochwertige Klangwiedergabe und erschien in der Computertechnologie in den allerletzten. Wenn jedoch die Wiedergabe schlechter ergangen ist, war die Synthese von realem klingenden Musikinstrument praktisch unmöglich. Daher haben einige Plattenfirmen ihre eigenen Standards eingeführt. Heute ist die am weitesten verbreitete, die FM-Synthese und Tischwellenverfahren.

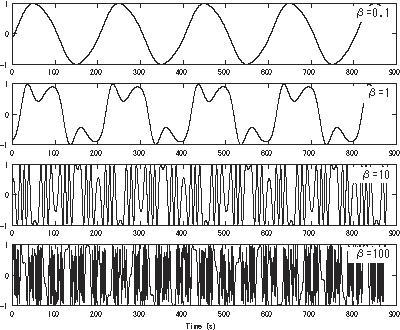

Im ersten Fall bedeutet dies, dass jeder natürlicher Klang, der kontinuierlich ist, in eine bestimmte Reihenfolge zerlegt werden kann (die Sequenz) einfachsten Harmonischen ein Abtastverfahren verwenden und in dem Computerspeicher Darstellung von Informationen erzeugen, auf dem Code basiert. Um die Verwendung den umgekehrten Prozess, aber in diesem Fall ist der unvermeidliche Verlust von einigen der Komponenten zu spielen, die auf der Qualität erscheinen.

Wenn tabellenWellenSynthese angenommen wird, dass es eine vorab erstellten Tabelle mit Beispielen für den Klang von Live-Instrumenten. Solche Beispiele sind Proben genannt. Zur gleichen Zeit des Team MIDI (Musical Instrument Digital Interface) wird verwendet, um zu spielen oft genug aus dem Code Art des Instruments zu erkennen, Tonhöhe, Dauer, Schallintensität und Dynamik des Wandels, Umgebungseinstellungen und anderen Merkmale. Dank dieser Art von Sound nah genug naturnah.

moderne Formate

Während früher hat die Basis für Standard-WAV genommen worden war (in der Tat, die sehr solide und ist in der Form einer Welle), im Laufe der Zeit ist es sehr ungünstig, wenn nur wegen der Tatsache, dass solche Dateien auf dem Speichermedium zu viel Raum einnehmen.

Im Laufe der Zeit, dieses Format zu komprimieren Technologien. Dementsprechend verändert und formatiert sich. Bekanntestes heute kann MP3, OGG, WMA, FLAC und viele andere genannt werden.

Bisher bleibt die Hauptparameter jeder Tondatei jedoch Abtastfrequenz (44,1 kHz ist Standard, obwohl die Werte oberhalb und unterhalb zu finden), und die Anzahl der Signalpegel (16 Bit, 32 Bit). Grundsätzlich Eine solche Digitalisierungs kann basierend auf dem analogen Primärsignal in der akustischen Typ-Computer als eine Darstellung der Information interpretiert werden (in der Art von beliebigen Ton ist ursprünglich analog).

Präsentationsvideo

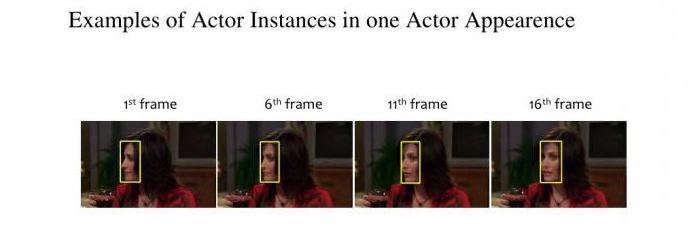

Wenn die Sound-Probleme schnell genug gelöst wurden, war das Video nicht alles so glatt. Das Problem war, dass der Clip, ein Film oder ein Videospiel, eine Kombination von Video und Audio. Es scheint, dass das, was könnte einfacher sein als Bildobjekte mit einer Skala zu kombinieren, zu verschieben? Wie sich herausstellte, war dies ein echtes Problem.

Alles, was aus technischen Sicht wichtig ist, dass zunächst das erste Bild jeder Szene zu erinnern, einen Schlüssel genannt wird, und erst dann die Unterschiede zu bewahren (Differenz-Frames). Und was schmerzhafter ist, digitalisiert oder erstellt Videos erhalten eine solche Größe, dass sie auf Ihrem Computer speichern oder auf Wechselmedien war einfach unmöglich.

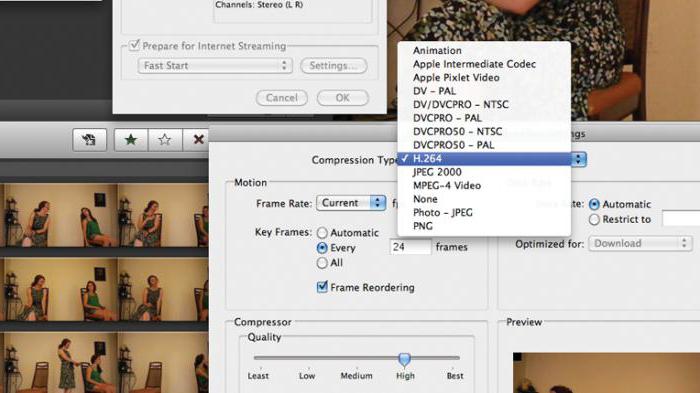

Das Problem wurde gelöst, als erscheinen AVI-Format, die einen bestimmten Universalbehälter darstellt, bestehend aus einer Reihe von Blöcken, die in einer beliebigen Informationen gespeichert werden können, so dass auch auf unterschiedliche Weise komprimieren. Somit kann auch die Dateien des gleichen Formats AVI zueinander kann erheblich variieren.

Und heute kann man viele andere gängige Videoformate erfüllen, sondern für alle von ihnen genutzt, um ihre eigenen Parameter und Parameterwerte, darunter vor allem die Anzahl der Bilder pro Sekunde.

Codecs und Decoder

Darstellung von Informationen in dem Computer als der Plan nicht möglich ist, ohne die Verwendung von Codecs und Decoder in der Kompression und Dekompression des Anfangsgehaltes während der Wiedergabe verwendet vorzustellen. Ihr Name schon sagt, dass einige kodieren (komprimieren) das Signal, die zweite – im Gegenteil – ausgepackt wird.

Sie sind es, für den Inhalt der Behälter jeder Größe verantwortlich sind, sowie die Größe der endgültigen Datei bestimmen. Darüber hinaus spielte die wichtige Rolle der Auflösungsparameter, wie für Rastergrafiken angezeigt. Aber heute können wir auch treffen UltraHD (4k).

Abschluss

Wenn einem gewissen Grad die oben summieren, kann es nur darauf hingewiesen, dass die modernen Computersystemen zunächst ausschließlich eines Binärcodes auf die Wahrnehmung funktionieren (sonst einfach nicht verstehen, dass sie). Und seine Verwendung beruht nicht nur Informationen, sondern auch alle bekannten Programmiersprachen heute. So zunächst, zu verstehen, wie das alles funktioniert, ist es notwendig, das Wesen der Verwendung von Sequenzen von Einsen und Nullen zu erreichen.